Der Anstieg des Deepfake-Betrugs hat eine neue Dimension des Risikos für Unternehmen geschaffen und die Grundlagen des digitalen Vertrauens untergraben. Diese KI-generierten Manipulationen – die Sprache, Gesichtsausdrücke und Gesten mit verblüffender Genauigkeit nachahmen können – sind nicht mehr nur erfahrenen Experten vorbehalten. Open-Source-Tools haben die Erstellung von Deepfakes demokratisiert und ermöglichen es sogar Personen mit minimalem technischen Fachwissen, überzeugende gefälschte Videos und gefälschte Bilder zu erstellen, wodurch ihre Bedrohung auf Social-Media-Plattformen verstärkt wird. Für Unternehmen sind die Folgen von Deepfake-Angriffen weitreichend, von Finanzbetrug und Datenschutzverletzungen bis hin zu Reputationsschäden und Vertrauensverlust der Stakeholder. Angesichts der Weiterentwicklung dieser Bedrohungen sind Deepfake-Erkennungstools unverzichtbar geworden. Dieser Leitfaden untersucht, wie solche Tools Unternehmen dabei helfen, ihren Betrieb zu schützen, das Vertrauen der Stakeholder zu sichern, umfassende Bewertungen durchzuführen und gegen neu auftretende Bedrohungen widerstandsfähig zu bleiben.

Was sind Deepfakes?

Deepfakes sind künstlich erstellte oder veränderte Videos, Bilder oder Audioaufnahmen, die so gestaltet sind, dass sie vollkommen echt aussehen und klingen. Sie werden mithilfe fortschrittlicher Techniken der künstlichen Intelligenz (KI) erstellt und ermöglichen es Betrügern, das Aussehen, die Stimme oder sogar das Verhalten einer Person in digitalen Inhalten zu manipulieren. Im Gegensatz zu einfachen, von KI generierten und unschuldig manipulierten Bildern können Deepfakes völlig neue Identitäten erstellen und reale Szenarien verfälschen, indem sie das Gesicht oder die Stimme einer Person durch das einer anderen ersetzen.

Was Deepfakes besonders gefährlich macht, ist ihre Verbindung zu synthetischer Identitätsbetrug. Bei diesen Machenschaften vermischen Betrüger echte und falsche Informationen – beispielsweise kombinieren sie eine echte Sozialversicherungsnummer mit erfundenen persönlichen Daten oder einem falschen Namen –, um eine falsche Identität zu erstellen. Dieses synthetische Profil kann dann verwendet werden, um Sicherheitsprüfungen zu umgehen, betrügerische Konten zu eröffnen oder Finanzverbrechen zu begehen, was die Erkennung von Deepfakes ohne spezielle Tools äußerst schwierig macht.

46% von Organisationen weltweit im Jahr 2022 mit synthetischem Identitätsbetrug konfrontiert.

Im Jahr 2022 waren weltweit 461.000 Organisationen Opfer von synthetischem Identitätsbetrug, und diese Zahl steigt weiter. Dies kostet die Unternehmen exorbitante Summen und gefährdet vertrauliche Informationen ahnungsloser Opfer.

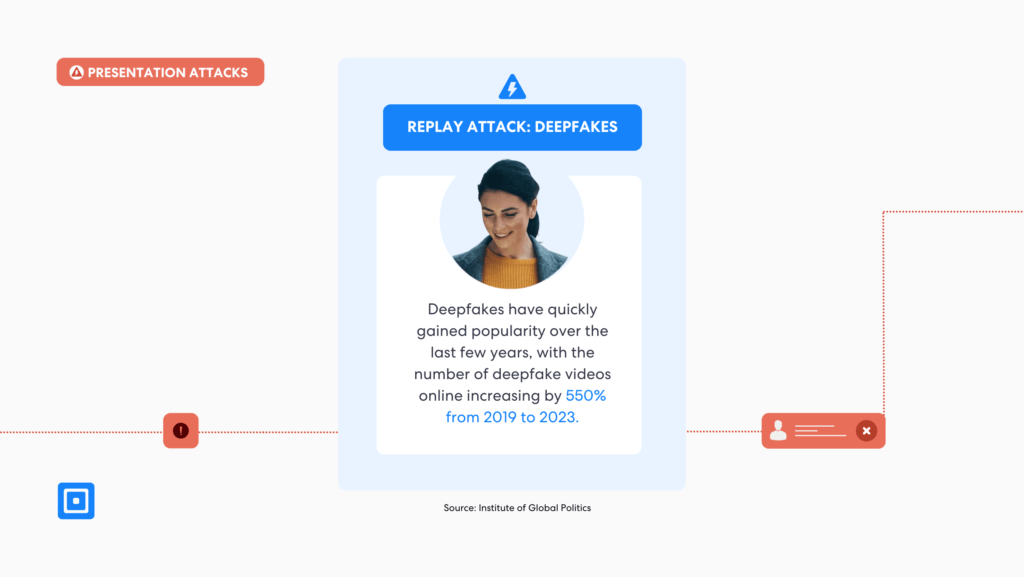

Von betrügerischen Finanztransaktionen bis hin zur Rufschädigung haben sich Deepfakes zu einem mächtigen Werkzeug für böswillige Akteure entwickelt. Wie die Northwestern Buffett Institute für globale Angelegenheiten, „In einer Welt voller Fehlinformationen und Misstrauen bietet KI immer ausgefeiltere Mittel, um Menschen von der Richtigkeit falscher Informationen zu überzeugen, die möglicherweise zu größeren politischen Spannungen, Gewalt oder sogar Krieg führen können.“ Diese ernüchternde Realität offenbart nicht nur die neue technische Bedrohung durch Deepfakes, sondern auch ihre umfassenderen gesellschaftlichen Auswirkungen.

Deepfake-Manipulation auf Social-Media-Plattformen

Die hyperrealistische Qualität von Deepfakes täuscht Zuschauer oft und entgeht herkömmlichen Erkennungsmethoden. Da diese Manipulationen immer überzeugender werden, sind fortschrittliche Technologien erforderlich, um die subtilen Merkmale von Deepfake-Videos und -Inhalten zu identifizieren.

Der Einsatz von KI und maschinellem Lernen bei der Erstellung von Deepfakes

Im Kern werden Deepfakes mithilfe fortgeschrittener und tiefgehender maschineller Lerntechniken erstellt, vor allem Generative Adversarial Networks (GANs) und neuronale Netzwerke. Diese Systeme sind darauf ausgelegt, menschliche Gesichtszüge, Ausdrücke und Sprache mit bemerkenswerter Präzision zu replizieren und zu manipulieren. Vereinfacht ausgedrückt funktioniert ein GAN wie ein andauernder Wettbewerb zwischen zwei Systemen künstlicher Intelligenz (KI): dem Generator und der Diskriminator.

Der Generator verhält sich wie ein hochqualifizierter Künstler und verwendet Methoden des maschinellen Lernens, um gefälschte Bilder, Videos oder Audiodateien zu erstellen. Dies geschieht durch die Analyse riesiger Datensätze mit Beispielen realer Gesichtszüge, Stimmmuster und Lippenbewegungen. Beispielsweise untersucht er, wie sich Münder bewegen, wenn bestimmte Wörter gesprochen werden, wie die Hautstruktur unter verschiedenen Lichtbedingungen aussieht und wie sich die Gesichtsmuskeln beim Ausdrücken bewegen. Mit der Zeit lernt der Generator, diese Details immer genauer nachzuahmen.

Der Diskriminator hingegen fungiert als sorgfältiger Kritiker. Er bewertet den vom Generator erstellten Inhalt und analysiert jedes Detail – bis hin zu subtilen Unstimmigkeiten in Lippenbewegungen, Hauttonübergängen oder Augenreflexionen – um festzustellen, ob die Ausgabe authentisch oder künstlich ist. Die Aufgabe des Diskriminators besteht darin, alles zu kennzeichnen, was fehl am Platz erscheint.

Der Generator verfeinert seine Arbeit ständig auf der Grundlage des Feedbacks, das er vom Diskriminator erhält. Mit der Zeit verbessert dieser Hin- und Her-Prozess die Fähigkeit des Generators, so überzeugende Inhalte zu produzieren, dass selbst der Diskriminator Schwierigkeiten hat, zu erkennen, ob es sich um gefälschte Inhalte handelt. Dieser fortlaufende Zyklus macht Deepfakes zunehmend realistisch und ohne spezielle Tools schwerer zu erkennen.

Gesichtsaustauschtechniken und ihre Auswirkungen auf die Deepfake-Erkennung

Eine der bekanntesten Anwendungen der Deepfake-Technologie ist das Face-Swapping, bei dem das Gesicht einer Person in einem Videoinhalt über das einer anderen Person gelegt wird. Diese Manipulationen können den Anschein erwecken, als hätte jemand Dinge gesagt oder getan, die er in Wirklichkeit nie getan hat. Das macht sie zu einem mächtigen Werkzeug für Desinformationskampagnen. Die Folgen gehen jedoch weit über Desinformation hinaus.

Diese neue Technologie hat auch zu Deepfake-Phishing geführt, einer besonders heimtückischen Form der Cyberkriminalität. Laut Stu Sjouwerman, ein Branchenexperte und Forbes-Autor für Internetsicherheit, sagt: „Phisher sind dafür bekannt, ihre Taktiken parallel zur technologischen Entwicklung weiterzuentwickeln. In den letzten Jahren hat Phishing erneut seine Form verändert und nutzt nun eine Technologie, die einige Experten als die gefährlichste Form von KI-gestützter Cyberkriminalität weltweit bezeichnen.“

Deepfakes sind eine der schwerwiegendsten neuen Risiken.

Diese Einschätzung wird unterstützt durch eine Studie durchgeführt vom University College London (UCL), bei dem 31 Experten die größten Bedrohungen durch KI-gesteuerte Kriminalität bewerteten. Die vom Dawes Centre for Future Crime des UCL finanzierte Studie hob Deepfakes als eines der schwerwiegendsten neuen Risiken hervor. Unter den 20 identifizierten schändlichen KI-Anwendungsfällen stachen Deepfakes aufgrund ihres Potenzials hervor, in den nächsten 15 Jahren großen Schaden anzurichten.

Die Zugänglichkeit der Deepfake-Erkennungstechnologie und ihre Risiken

Die Verbreitung von Open-Source-Tools zur Erstellung von Deepfakes hat diese Technologie einem breiteren Publikum zugänglich gemacht. Selbst Personen mit minimalem technischen Fachwissen können jetzt Deepfakes mit Software wie erstellen. DeepFaceLab, ein System, das über 951.000.000 Deepfake-Kreationen antreibt. Diese Zugänglichkeit bedeutet, dass Deepfake-Bedrohungen nicht mehr auf hochqualifizierte Entwickler oder gut finanzierte cyberkriminelle Organisationen beschränkt sind, sondern mittlerweile eine weit verbreitete Cyberbedrohung darstellen, die von praktisch jedem ausgehen kann, der einen Computer und eine Internetverbindung hat.

Gartner hat die Risiken kommentiert, die Deepfakes für Unternehmen weltweit darstellen, und erklärt: „Im letzten Jahrzehnt gab es mehrere Wendepunkte in den Bereichen der KI, die die Erstellung synthetischer Bilder ermöglichen. Diese künstlich erzeugten Bilder der Gesichter echter Menschen, bekannt als Deepfakes, können von böswilligen Akteuren verwendet werden, um die biometrische Authentifizierung zu untergraben oder ineffizient zu machen“, sagte Akif Khan, VP Analyst bei Gartner. „Infolgedessen könnten Organisationen beginnen, die Zuverlässigkeit von Lösungen zur Identitätsüberprüfung und -authentifizierung in Frage zu stellen, da sie nicht erkennen können, ob es sich bei dem Gesicht der zu verifizierenden Person um eine echte Person oder einen Deepfake handelt.“

Virale Verbreitung von Deepfakes: Die Rolle sozialer Medien

Einmal erstellt, können sich Deepfakes schnell auf verschiedenen Social-Media-Plattformen verbreiten und nutzen emotional aufgeladene oder kontroverse Narrative, um an Zugkraft zu gewinnen. Diese Viralität verschärft die Herausforderung, ihre Auswirkungen einzudämmen, da sie die öffentliche Wahrnehmung beeinflussen können, bevor sie entdeckt werden.

Finanzbetrug und Deepfake-gestützte Machenschaften

Deepfakes werden immer häufiger als Waffe eingesetzt und bergen erhebliche Risiken für Unternehmen. Betrüger haben Deepfakes-Audio- und Videoaufnahmen verwendet, um sich als Führungskräfte auszugeben und Mitarbeiter dazu zu bringen, Geld zu überweisen oder vertrauliche Informationen preiszugeben.

Ein bemerkenswerter Fall In Hongkong ereignete sich ein Vorfall, bei dem ein Finanzmitarbeiter eines multinationalen Unternehmens dazu verleitet wurde, $25 Millionen zu überweisen. Laut Angaben der Hongkonger Polizei nutzten die Angreifer Deepfake-Technologie, um sich während einer Videokonferenz glaubhaft als CEO des Unternehmens auszugeben.

Manipulierte Medien können dem Markenimage eines Unternehmens erheblichen Schaden zufügen. Ein Deepfake-Video, das einen CEO in einer kompromittierenden Situation zeigt, könnte beispielsweise zu öffentlichen Gegenreaktionen führen und das Vertrauen der Stakeholder untergraben.

Herausforderungen und zukünftige Richtungen im Kampf gegen Deepfakes

Leider stehen viele unterdurchschnittliche Erkennungsalgorithmen vor Herausforderungen wie hohen Falsch-Positiv-Raten und der zunehmenden Komplexität von Technologien zur Erstellung von Deepfakes. Um diesen Bedrohungen immer einen Schritt voraus zu sein, sind kontinuierliche Updates und die Zusammenarbeit zwischen Unternehmen und Technologieentwicklern unerlässlich.

Um Deepfakes in Echtzeit zu erkennen, ist die Erfassung und Analyse einer großen und unvoreingenommener Datensatz ist notwendig.

Wie in der Studie „Deepfake Video Detection: Challenges and Opportunities“ (Kaur et al., 2024), „Trotz der erheblichen Fortschritte bei Deepfake-Videos und Erkennungsalgorithmen bleiben einige entscheidende Herausforderungen für die derzeitigen Methoden zur Erkennung von Deepfake-Videos ungelöst. Um Deepfakes in Echtzeit zu erkennen, ist die Erfassung und Analyse eines großen und unvoreingenommenen Datensatzes erforderlich. Das Sammeln von Echtzeitdaten ist eine der Hauptbeschränkungen der auf Deep Learning (DL) basierenden Methode. Leider können viele Echtzeitanwendungsbereiche nicht auf große Mengen neuer Daten zugreifen.“

Dies zeigt ein zentrales Problem der meisten Deepfake-Erkennungssysteme: Tools sind nur so effektiv wie die Datensätze, mit denen sie trainiert werden. Ohne Zugriff auf vielfältige, aktuelle Daten haben selbst fortschrittliche KI-Erkennungsmodelle Schwierigkeiten, mit immer ausgefeilteren Deepfakes Schritt zu halten. Unternehmen müssen nicht nur in zuverlässige Deepfake-Erkennungstechnologien investieren, sondern auch bessere Praktiken zum Datenaustausch und zur branchenübergreifenden Zusammenarbeit unterstützen, um diese Lücke zu schließen.

Deepfake-Erkennungstools zum Schutz des digitalen Vertrauens

Um das Problem der Manipulation durch Deepfakes zu lösen, müssen Unternehmen fortschrittliche Tools und Software zur Deepfake-Erkennung einsetzen. Diese Systeme basieren auf einer Kombination aus Deep-Learning-Techniken und maschinellen Lernalgorithmen, um digitale Medien (einschließlich Bilder, Videos und Audio) sorgfältig auf Anzeichen von generierten oder manipulierten Inhalten zu analysieren.

95% von allen Standardmäßige Kunden-Onboardingprozesse können das Vorhandensein gefälschter Ausweise nicht erkennen.

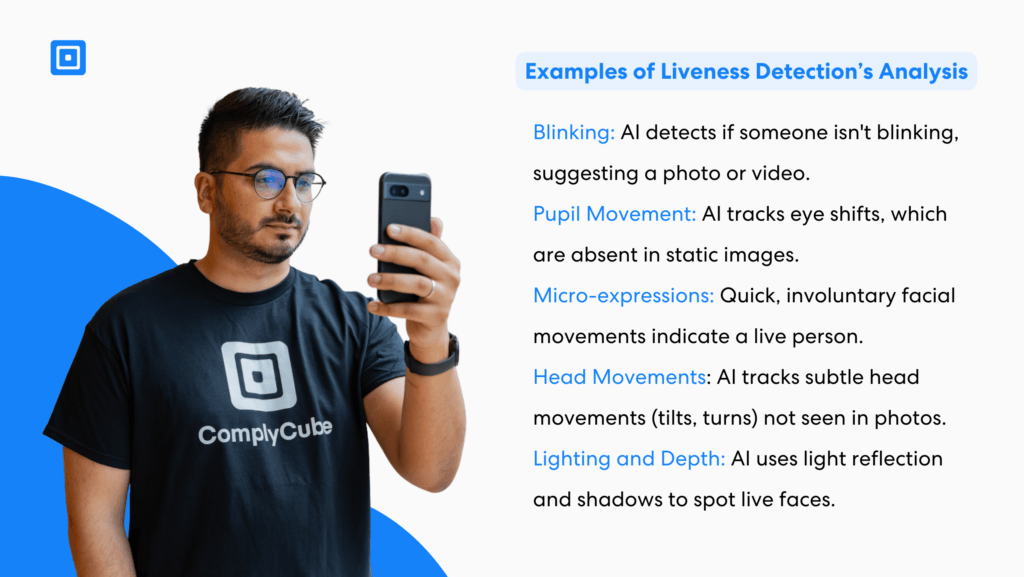

Eine innovative Deepfake-Erkennungsplattform in diesem Bereich ist ComplyCube. Die Plattform Technologie zur Lebendigkeitserkennung setzt einen neuen Maßstab in der biometrischen Verifizierung und überprüft, ob die biometrischen Daten von einer echten, lebenden Person stammen und nicht von statischen Bildern, aufgezeichneten Videos oder KI-generierten Deepfakes.

Angetrieben von fortschrittlichen KI- und maschinellen Lernalgorithmen analysiert es Mikroausdrücke, Hautstruktur, Gesichtserkennungsmuster und Interaktionen mit der Umgebung in Echtzeit. Durch einen multimodalen Ansatz – der aktive Prüfungen, wie geführte Kopfbewegungen, mit passiver Analyse kombiniert, die unbemerkt im Hintergrund abläuft – erkennt ComplyCube nahtlos ausgeklügelte Spoofing-Versuche, darunter gedruckte Fotos, 3D-Masken und Videowiedergaben. Dieses robuste System bietet eine hochpräzise, sichere und reibungslose Identitätsüberprüfung und ermöglicht es Unternehmen, Betrug sicher zu verhindern.

Widerstandsfähigkeit gegen Deepfake-Bedrohungen mit Deepfake-Erkennungstools

Deepfakes stellen eine gewaltige Herausforderung für das digitale Vertrauen dar, insbesondere für Unternehmen, die einen sicheren und zuverlässigen Betrieb aufrechterhalten möchten. Durch den Einsatz fortschrittlicher Deepfake-Erkennungstools und deren Integration in umfassende Cybersicherheitsrahmen können Unternehmen die Risiken manipulierter Medien mindern.

ComplyCube ist eine leistungsstarke Plattform, die die wachsende Herausforderung der Deepfake-Erkennung mithilfe fortschrittlicher Techniken des maschinellen Lernens und Deep-Learning-Technologien angehen soll. Durch die Kombination von Gesichtserkennung, Dokumentenanalyse und Anti-Spoofing-Maßnahmen gewährleistet die Plattform eine sichere und zuverlässige Identitätsüberprüfung, selbst in einer Zeit, in der die Erkennung von Deepfake-Videos immer schwieriger wird.

Robuste Gesichtserkennung und Ähnlichkeitsanalyse: ComplyCube verwendet ISO 30107-3 und PAD Level 2-zertifizierte biometrische Echtheitserkennung, um eine genaue Gesichtserkennung zu gewährleisten. Durch den Vergleich von echten Videos und biometrischen Datenproben unterscheidet das Tool effektiv echte Benutzer von manipulierten Identitäten. Seine Deepfake-Erkennungsfunktionen werden durch die Analyse von Gesichtszügen, Verhaltensmustern und anderen einzigartigen biologischen Signalen verbessert, wodurch eine zusätzliche Ebene der Verifizierungssicherheit geschaffen wird.

Erweiterte Dokumentenüberprüfung: Mithilfe einer Kombination aus fortschrittlichen maschinellen Lerntechniken und menschlicher Expertise analysiert ComplyCube eine breite Palette von Ausweisdokumenten – wie Reisepässe, Führerscheine, Personalausweise, Aufenthaltsgenehmigungen und Visastempel. Bei diesem Überprüfungsprozess werden Dokumente mit vertrauenswürdigen Datensätzen abgeglichen, um Anzeichen von Manipulation, Fälschung oder Blacklisting zu erkennen und sicherzustellen, dass sie authentisch und unverändert sind.

Hochmoderne Technologie zur Lebenderkennung: Mit der KI-gestützten PAD-Level-2-Echtheitserkennung kann ComplyCube Deepfake-Videos erkennen und Identitätsbetrugsversuche verhindern. Dieses System verwendet Anti-Spoofing-Algorithmen, um subtile Diskrepanzen zwischen echten Videos und manipulierten Medien zu erkennen und so vor immer anspruchsvolleren Herausforderungen bei der Deepfake-Erkennung zu schützen.

Nahtlose biometrische Einarbeitung: ComplyCube bietet eine geführte Gesichtserfassung und optimiert den biometrischen Einarbeitungsprozess für Branchen wie Finanzen, Telekommunikation, Reisen und Unternehmensdienstleistungen. Durch die Konzentration auf hochwertige Datensatzintegration und kontinuierliche Systemoptimierung bietet das Tool einen reibungslosen und genauen Authentifizierungsprozess.

Angesichts der zunehmenden Bedrohungen durch KI-generierte gefälschte Inhalte spielt ein Partner wie ComplyCube eine wesentliche Rolle bei der Stärkung des digitalen Vertrauens. Sein umfassender Ansatz zur Gesichtserkennung, Dokumentenüberprüfung und Deepfake-Erkennung hilft Unternehmen, den Herausforderungen immer einen Schritt voraus zu sein und gleichzeitig die Integrität ihrer Identitätsüberprüfungsprozesse sicherzustellen.

Kontaktieren Sie einen von ComplyCube Compliance-Experten Informieren Sie sich noch heute darüber, wie Sie Ihr Unternehmen schützen können.