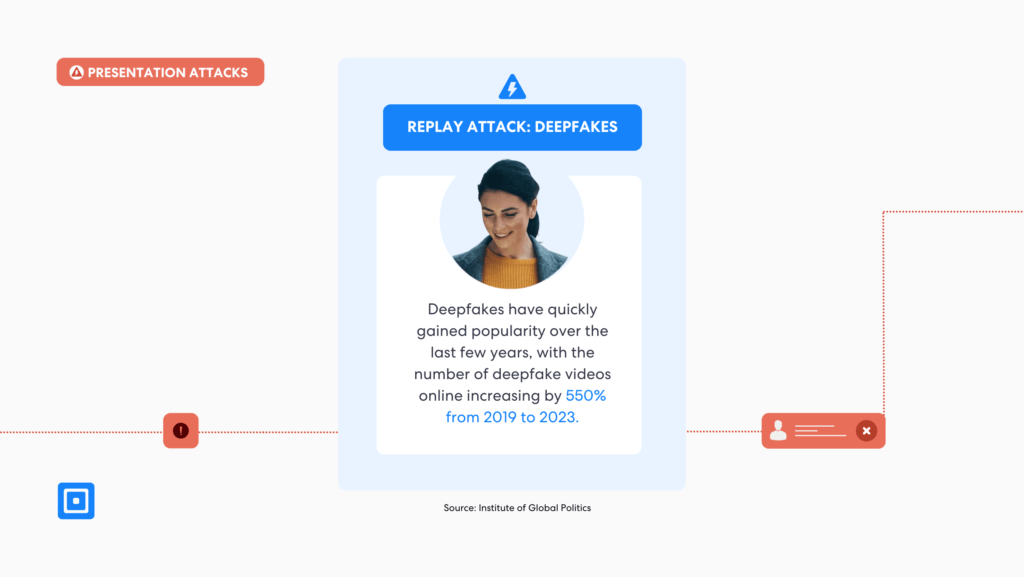

L’essor des fraudes deepfake a introduit une nouvelle dimension de risque pour les entreprises, érodant les fondements de la confiance numérique. Ces manipulations générées par l’IA, capables d’imiter la parole, les expressions faciales et les gestes avec une précision surprenante, ne sont plus réservées aux experts qualifiés. Les outils open source ont démocratisé la création de deepfakes, permettant même à ceux qui ont une expertise technique minimale de produire de fausses vidéos et de fausses images convaincantes, amplifiant ainsi leur menace sur les plateformes de médias sociaux. Pour les entreprises, les conséquences des attaques deepfake sont de grande envergure, allant de la fraude financière et des violations de données à l’atteinte à la réputation et à la perte de confiance des parties prenantes. À mesure que ces menaces évoluent, les outils de détection de deepfakes sont devenus indispensables. Ce guide examine comment ces outils aident les entreprises à protéger leurs opérations, à garantir la confiance des parties prenantes, à mener des évaluations complètes et à rester résilientes face aux menaces émergentes.

Que sont les Deepfakes ?

Les deepfakes sont des vidéos, des images ou des enregistrements audio créés ou modifiés artificiellement, conçus pour paraître et sonner parfaitement réels. Ils sont générés à l'aide de techniques avancées d'intelligence artificielle (IA), permettant aux fraudeurs de manipuler l'apparence, la voix ou même le comportement d'une personne dans un contenu numérique. Contrairement aux images simples générées par l'IA et manipulées de manière innocente, les deepfakes peuvent créer des identités entièrement nouvelles et falsifier des scénarios du monde réel en remplaçant le visage ou la voix d'une personne par celle d'une autre.

Ce qui rend les deepfakes particulièrement dangereux est leur lien avec fraude à l'identité synthétique. Dans ces stratagèmes, les fraudeurs mélangent des informations réelles et fausses – par exemple en combinant un véritable numéro de sécurité sociale avec des informations personnelles fabriquées ou un faux nom – pour créer une fausse identité. Ce profil synthétique peut ensuite être utilisé pour contourner les contrôles de sécurité, ouvrir des comptes frauduleux ou commettre des délits financiers, ce qui rend la détection des deepfakes extrêmement difficile sans outils spécialisés.

46% des organisations fraude à l’identité synthétique à l’échelle mondiale en 2022.

Pas moins de 461 millions d'organisations dans le monde ont été confrontées à une fraude à l'identité synthétique en 2022, et ce nombre continue de croître, coûtant aux entreprises des sommes exorbitantes et compromettant les informations sensibles de victimes sans méfiance.

Des transactions financières frauduleuses au sabotage de réputation, les deepfakes sont devenus un outil puissant pour les acteurs malveillants. Comme l'a noté le Institut Buffett pour les affaires mondiales de Northwestern, "Dans un monde où règnent la désinformation et la méfiance, l’IA fournit des moyens de plus en plus sophistiqués pour convaincre les gens de la véracité de fausses informations qui ont le potentiel de conduire à une plus grande tension politique, à la violence, voire à la guerre. » Cette réalité qui donne à réfléchir révèle non seulement la nouvelle menace technique posée par les deepfakes, mais aussi leur impact sociétal plus large.

Manipulation de deepfakes sur les plateformes de médias sociaux

Le caractère hyperréaliste des deepfakes trompe souvent les spectateurs et échappe aux méthodes de détection traditionnelles. À mesure que ces manipulations deviennent plus convaincantes, des technologies avancées sont nécessaires pour identifier les marqueurs subtils des vidéos et contenus deepfakes.

L'utilisation de l'IA et de l'apprentissage automatique dans la création de deepfakes

À la base, les deepfakes sont créés à l'aide de techniques avancées et approfondies d'apprentissage automatique, principalement des réseaux antagonistes génératifs (GAN) et des réseaux neuronaux. Ces systèmes sont conçus pour reproduire et manipuler les caractéristiques, les expressions et la parole humaines avec une précision remarquable. Pour simplifier, un GAN fonctionne comme une compétition permanente entre deux systèmes d'intelligence artificielle (IA) : le générateur et le discriminateur.

Le générateur agit comme un artiste hautement qualifié, utilisant des méthodes d'apprentissage automatique pour créer de fausses images, vidéos ou fichiers audio. Pour ce faire, il analyse des ensembles de données massifs remplis d'exemples de traits du visage, de modèles de voix et de mouvements des lèvres du monde réel. Par exemple, il étudie la façon dont les bouches bougent lorsque certains mots sont prononcés, la façon dont la texture de la peau apparaît sous différentes conditions d'éclairage et la façon dont les muscles du visage se déplacent pendant les expressions. Au fil du temps, le générateur apprend à imiter ces détails avec une précision croissante.

Le discriminateur, quant à lui, joue le rôle d'un critique méticuleux. Il évalue le contenu créé par le générateur, en analysant chaque détail, jusqu'aux subtiles incohérences dans les mouvements des lèvres, les transitions de tons de peau ou les reflets des yeux, pour déterminer si le résultat est authentique ou synthétique. Le rôle du discriminateur est de signaler tout ce qui semble déplacé.

Le générateur continue d'affiner son travail en fonction des retours qu'il reçoit du discriminateur. Au fil du temps, ce processus de va-et-vient améliore la capacité du générateur à produire un contenu si convaincant que même le discriminateur a du mal à déterminer s'il s'agit d'un faux contenu. Ce cycle continu est ce qui rend les deepfakes de plus en plus réalistes et difficiles à détecter sans outils spécialisés.

Techniques d'échange de visages et leurs implications pour la détection des deepfakes

L’une des utilisations les plus connues de la technologie deepfake est l’échange de visages, qui consiste à superposer le visage d’une personne à celui d’une autre dans un contenu vidéo. Ces manipulations peuvent donner l’impression que quelqu’un a dit ou fait des choses qu’il n’a jamais faites, ce qui en fait un outil puissant pour les campagnes de désinformation. Cependant, les implications vont bien au-delà de la désinformation.

Cette nouvelle technologie a également donné naissance au phishing deepfake, une forme de cybercriminalité particulièrement insidieuse. Stu Sjouwerman, expert du secteur et contributeur de Forbes sur la sécurité Internet, a déclaré : « Les hameçonneurs sont connus pour faire évoluer leurs tactiques en fonction de l’évolution de la technologie. Ces dernières années, le phishing a de nouveau changé de forme, utilisant une technologie que certains experts qualifient de forme de cybercriminalité alimentée par l’IA la plus dangereuse au monde. »

Les deepfakes sont l'une des nouvelles technologies les plus sérieuses risques.

Cette évaluation est appuyée par une étude L'étude, menée par l'University College London (UCL), a permis à 31 experts de classer les menaces les plus importantes posées par la criminalité induite par l'IA. Cette recherche, financée par le Dawes Centre for Future Crime de l'UCL, a mis en évidence les deepfakes comme l'un des risques émergents les plus graves. Parmi les 20 utilisations néfastes de l'IA identifiées, les deepfakes se sont distingués par leur potentiel à causer des dommages généralisés au cours des 15 prochaines années.

L'accessibilité de la technologie de détection des deepfakes et ses risques

La prolifération d'outils open source de création de deepfakes a rendu cette technologie accessible à un public plus large. Même les personnes disposant d'une expertise technique minimale peuvent désormais produire des deepfakes à l'aide de logiciels tels que Laboratoire DeepFace, un système qui alimente plus de 95% de créations deepfake. Cette accessibilité signifie que les menaces deepfake ne se limitent plus aux développeurs hautement qualifiés ou aux organisations cybercriminelles bien financées, mais qu'elles constituent désormais une cybermenace généralisée qui peut émerger de pratiquement n'importe qui disposant d'un ordinateur et d'une connexion Internet.

Gartner a commenté les risques que les deepfakes représentent pour les entreprises du monde entier, en déclarant : « Au cours de la dernière décennie, plusieurs points d'inflexion dans les domaines de l'IA se sont produits, permettant la création d'images synthétiques. Ces images générées artificiellement de visages de personnes réelles, connues sous le nom de deepfakes, peuvent être utilisées par des acteurs malveillants pour compromettre l'authentification biométrique ou la rendre inefficace », a déclaré Akif Khan, vice-président analyste chez Gartner. « En conséquence, les entreprises pourraient commencer à remettre en question la fiabilité des solutions de vérification et d’authentification d’identité, car elles ne seront pas en mesure de déterminer si le visage de la personne vérifiée est une personne réelle ou un deepfake. »

Propagation virale des deepfakes : le rôle des réseaux sociaux

Une fois créés, les deepfakes peuvent se propager rapidement sur diverses plateformes de médias sociaux, exploitant des récits chargés d’émotion ou controversés pour gagner en popularité. Cette viralité complique la tâche d’atténuer leur impact, car ils peuvent influencer la perception du public avant d’être détectés.

Fraude financière et stratagèmes utilisant le deepfake

Les deepfakes sont de plus en plus utilisés comme armes, ce qui crée des risques importants pour les entreprises. Les fraudeurs ont utilisé des fichiers audio et vidéo deepfakes pour se faire passer pour des dirigeants, trompant ainsi les employés afin qu'ils transfèrent des fonds ou divulguent des informations sensibles.

Un cas notable L'incident s'est produit à Hong Kong, où un employé financier d'une multinationale a été trompé en lui faisant transférer 1725 millions de TP. Selon la police de Hong Kong, les assaillants ont utilisé la technologie deepfake pour se faire passer de manière convaincante pour le PDG de l'entreprise lors d'une visioconférence.

Les médias manipulés peuvent nuire gravement à l'image de marque d'une entreprise. Une vidéo deepfake montrant un PDG dans une situation compromettante, par exemple, pourrait provoquer une réaction négative de l'opinion publique et éroder la confiance des parties prenantes.

Défis et orientations futures dans la lutte contre les deepfakes

Malheureusement, de nombreux algorithmes de détection de qualité inférieure sont confrontés à des défis tels que des taux élevés de faux positifs et la sophistication croissante des technologies de création de deepfakes. Des mises à jour continues et une collaboration entre les entreprises et les développeurs technologiques sont essentielles pour garder une longueur d'avance sur ces menaces.

Pour détecter les deepfakes en temps réel, en acquérant et en analysant une large ensemble de données impartial est nécessaire.

Comme indiqué dans l'étude « Détection de vidéos deepfakes : défis et opportunités » (Kaur et al., 2024),« Malgré les progrès significatifs réalisés dans le domaine des vidéos deepfake et des algorithmes de détection, plusieurs défis cruciaux restent non résolus pour les méthodes actuelles de détection de vidéos deepfake. Pour détecter les deepfakes en temps réel, il est nécessaire d'acquérir et d'analyser un ensemble de données volumineux et impartial. La collecte de données en temps réel est l'une des principales limites de la méthode basée sur le Deep Learning (DL). Malheureusement, de nombreux domaines d'application en temps réel ne peuvent pas accéder à de grandes quantités de nouvelles données. »

Cela met en évidence un problème clé avec la plupart des systèmes de détection de deepfakes : les outils ne sont efficaces que dans la mesure où les ensembles de données sur lesquels ils sont formés le sont. Sans accès à des données diverses et actualisées, même les modèles de détection d'IA avancés ont du mal à suivre le rythme des deepfakes de plus en plus sophistiqués. Les entreprises doivent non seulement investir dans des technologies fiables de détection de deepfakes, mais également soutenir de meilleures pratiques de partage des données et de collaboration entre les secteurs pour combler cette lacune.

Outils de détection de deepfake pour préserver la confiance numérique

Pour relever le défi de la manipulation des deepfakes, les entreprises doivent adopter des outils et des logiciels avancés de détection des deepfakes. Ces systèmes s'appuient sur une combinaison de techniques d'apprentissage profond et d'algorithmes d'apprentissage automatique pour analyser méticuleusement les médias numériques (y compris les images, les vidéos et l'audio) à la recherche de signes de contenu généré ou manipulé.

95% de tous Les processus d’intégration client standard ne parviennent pas à détecter la présence de fausses pièces d’identité.

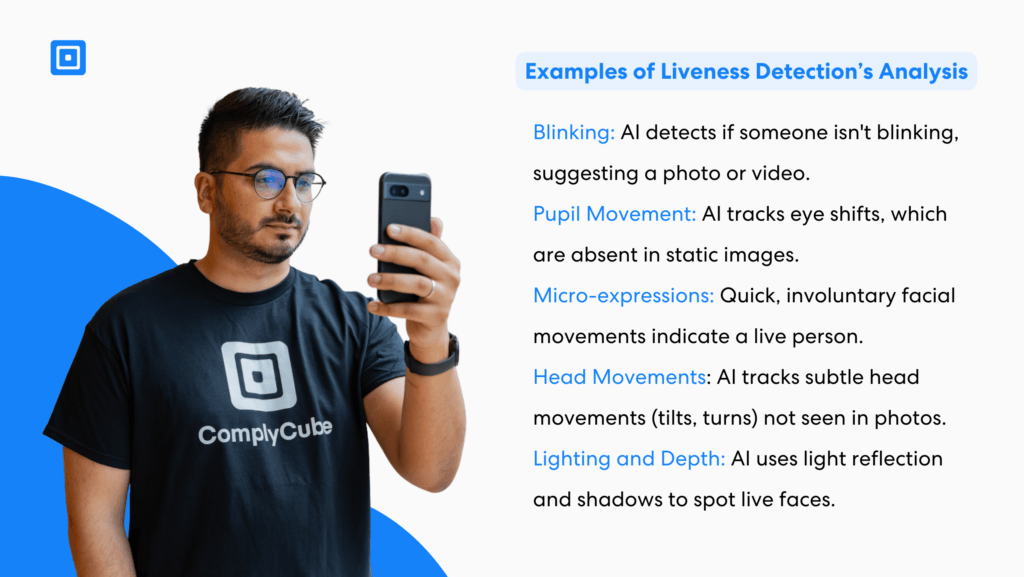

ComplyCube est une plate-forme innovante de détection de deepfakes dans ce domaine. technologie de détection de vie établit une nouvelle référence en matière de vérification biométrique, en vérifiant que les données biométriques proviennent d'une personne réelle et vivante plutôt que d'images statiques, de vidéos préenregistrées ou de deepfakes générés par l'IA.

Alimenté par des algorithmes avancés d'IA et d'apprentissage automatique, il analyse les micro-expressions, la texture de la peau, les modèles de reconnaissance faciale et les interactions environnementales en temps réel. Grâce à une approche multimodale, combinant des contrôles actifs, comme les mouvements de tête guidés, avec une analyse passive qui fonctionne silencieusement en arrière-plan, ComplyCube détecte de manière transparente les tentatives d'usurpation sophistiquées, notamment les photos imprimées, les masques 3D et les rediffusions vidéo. Ce système robuste offre une vérification d'identité extrêmement précise, sécurisée et fluide, permettant aux entreprises de prévenir la fraude en toute confiance.

Renforcer la résilience face aux menaces Deepfake grâce aux outils de détection Deepfake

Les deepfakes représentent un défi de taille pour la confiance numérique, en particulier pour les entreprises qui s’efforcent de maintenir des opérations sûres et fiables. En adoptant des outils avancés de détection des deepfakes et en les intégrant dans des cadres de cybersécurité complets, les organisations peuvent atténuer les risques posés par les médias manipulés.

ComplyCube est une plateforme puissante conçue pour répondre au défi croissant de la détection des deepfakes en exploitant des techniques avancées d'apprentissage automatique et des technologies d'apprentissage profond. En combinant la reconnaissance faciale, l'analyse de documents et des mesures anti-usurpation d'identité, la plateforme garantit une vérification d'identité sûre et fiable, même à une époque où la détection de vidéos deepfakes devient de plus en plus difficile.

Reconnaissance faciale robuste et analyse de similarité : ComplyCube utilise la détection biométrique de l'activité certifiée ISO 30107-3 et PAD niveau 2 pour garantir une reconnaissance faciale précise. En comparant des vidéos réelles et des échantillons de données biométriques, l'outil distingue efficacement les utilisateurs authentiques des identités manipulées. Ses capacités de détection de deepfake sont améliorées en analysant les traits du visage, les modèles de comportement et d'autres signaux biologiques uniques, créant ainsi une couche supplémentaire d'assurance de vérification.

Vérification avancée des documents: En combinant des techniques avancées d'apprentissage automatique et une expertise humaine, ComplyCube analyse une large gamme de documents d'identité, tels que les passeports, les permis de conduire, les cartes nationales d'identité, les permis de séjour et les tampons de visa. Ce processus de vérification consiste à recouper les documents avec des ensembles de données fiables pour identifier les signes de falsification, de falsification ou de liste noire, garantissant ainsi leur authenticité et leur inaltérabilité.

Technologie de détection de vie de pointe:Avec la détection d'activité PAD-Level 2 basée sur l'IA, ComplyCube peut détecter les vidéos deepfake et empêcher les tentatives d'usurpation d'identité. Ce système utilise des algorithmes anti-usurpation d'identité pour identifier les différences subtiles entre les vidéos réelles et les médias manipulés, protégeant ainsi contre les défis de détection deepfake de plus en plus sophistiqués.

Intégration biométrique transparente : ComplyCube offre une expérience de capture faciale guidée, simplifiant le processus d'intégration biométrique pour des secteurs tels que la finance, les télécommunications, les voyages et les services aux entreprises. En mettant l'accent sur l'intégration d'ensembles de données de haute qualité et l'optimisation continue du système, l'outil offre un processus d'authentification fluide et précis.

Face aux menaces croissantes liées aux faux contenus générés par l’IA, un partenaire comme ComplyCube joue un rôle essentiel dans le renforcement de la confiance numérique. Son approche globale de la reconnaissance faciale, de la vérification des documents et de la détection des deepfakes aide les organisations à garder une longueur d’avance sur les défis tout en garantissant l’intégrité de leurs processus de vérification d’identité.

Contactez l'un des ComplyCube experts en conformité aujourd'hui pour plus d'informations sur la façon de protéger votre organisation.