La politique mondiale repose sur des récits changeants, réécrits par des millions de personnes chaque jour, à l’image de nos opinions qui sont façonnées par la dernière chose que nous lisons sur Twitter. Lorsque ce que nous lisons correspond aux opinions de personnes réelles de tous horizons, nous bénéficions certainement des avantages de la liberté d’expression, une utilisation clairement démocratique de la technologie. Cependant, lorsque ce que nous lisons est la conséquence d’un manque de vérifications d’identité nécessaires et de robots frauduleux sur les réseaux sociaux, c’est tout sauf démocratique – c’est une tentative de contrôler un espace qui devrait être le nôtre. L’absence de pratiques de vérification des réseaux sociaux sur les plateformes en ligne a permis à des acteurs malveillants d’orienter les discussions mondiales, diffusant souvent de fausses informations pour atteindre un agenda politique spécifique. La mise en œuvre de la détection des faux comptes sur les réseaux sociaux est donc devenue essentielle.

Les faux comptes et les bots sont étroitement liés à la politique internationale depuis longtemps, provoquant une controverse mondiale au cours de la dernière décennie. Des centaines, voire des milliers d'articles de presse, ont fait état d'une augmentation de l'activité des bots sur les plateformes sociales à l'approche des élections. À l'approche des élections britanniques de 2024, des articles tels que l'article de Global Witness, « Une enquête révèle que du contenu publié par des comptes de type bot sur X a été vu 150 millions de fois « À l’approche des élections britanniques », a souligné que les opinions du grand public ne seraient pas le seul facteur décisif.

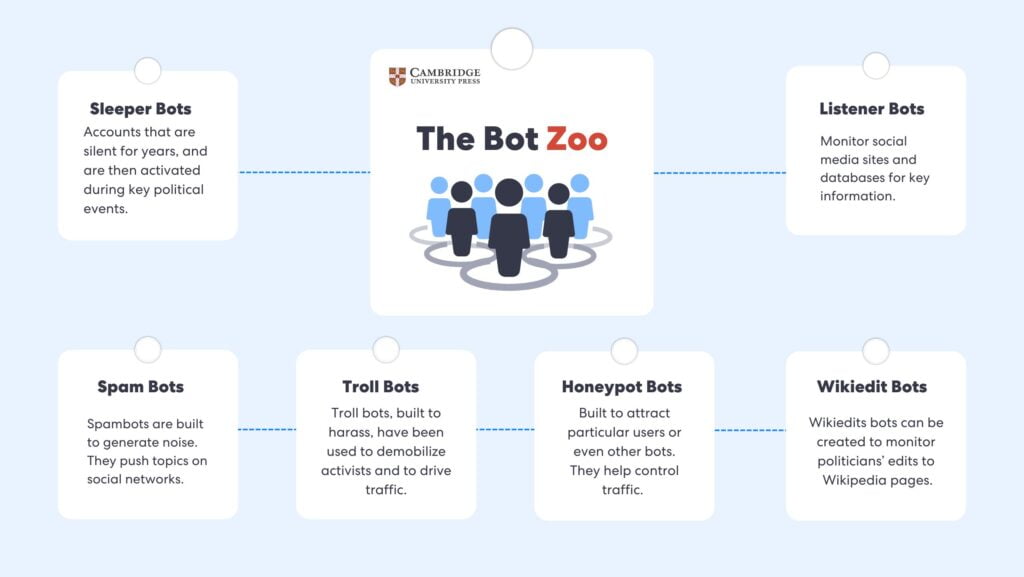

Il est intéressant de noter que les plateformes médiatiques ne sont pas les seules à s’être exprimées sur le trafic politique généré par les robots. Les universitaires ont également pris le problème en main au cours des 20 dernières années. Lors des premières discussions sur les logiciels malveillants, T. Holz a écrit un article critique en 2005, « A Short Visit to the Bot Zoo ». Il s’agissait de l’un des premiers articles à aborder les attaques de robots en ligne, qui à l’époque étaient principalement utilisées pour le vol d’identité en masse, les attaques par déni de service distribué (DDoS) ou l’envoi de spam.

Holz a réussi à capturer les caractéristiques clés de ces robots, en soulignant leurs traits et leurs comportements. Il a également créé une structure permettant de catégoriser différents types de robots. Les universitaires de Cambridge ont repris les travaux de Holz en 2020, ainsi que de nombreux autres articles et études de premier plan sur le comportement des robots depuis 2005, et ont également créé leur propre classification, en se concentrant spécifiquement sur l'activité en ligne des robots politiques.

Un zoo de robots politiques

Les universitaires de Cambridge University Press ont beaucoup écrit sur l’utilisation et les menaces des robots politiques. Samuel C. Woolley a pu faire de réels progrès dans son article de 2020, « Bots and Computational Propaganda : Automatisation pour la communication et le contrôle.” Il affirme dans cet article que « la présence [de] robots sociaux dans les discussions politiques en ligne peut créer trois problèmes tangibles : premièrement, l’influence peut être redistribuée sur des comptes suspects qui peuvent être exploités à des fins malveillantes ; deuxièmement, la conversation politique peut devenir encore plus polarisée ; troisièmement, la diffusion de fausses informations et d’informations non vérifiées peut être renforcée. »

Il continue de reproduire la classification Bot-Zoo originale de Holz mais applique le concept à robots politiques, en identifiant les catégories suivantes :

- Bots d'auditeurs : Peut surveiller les sites de médias sociaux et les bases de données pour obtenir des informations clés, mais également suivre et communiquer ce qu'ils trouvent.

- Robots spammeurs : Les spambots, au contraire, sont conçus pour générer du bruit.

- Robots Wikiedit : Des robots Wikiedit peuvent être créés pour surveiller les modifications apportées par les politiciens aux pages Wikipédia.

- Robots dormants : Les bots dormants sont des comptes de réseaux sociaux qui sont hébergés sur un site comme Twitter, pratiquement inutilisés pendant des années, pour générer une présence en ligne plus réaliste. Ils sont ensuite activés lors d'événements politiques clés.

- Robots trolls : Les robots trolls, conçus pour harceler, ont été utilisés pour troller les militants essayant de s'organiser et de communiquer sur Twitter, mais peuvent également diriger le trafic d'une cause, d'un produit ou d'une idée vers une autre.

- Bots pots de miel : Conçu pour attirer des utilisateurs particuliers ou même d'autres robots.

La politique contemporaine

La politique moderne est de plus en plus étroitement liée aux réseaux sociaux, où la bataille pour l’opinion publique est souvent influencée par des acteurs malveillants plutôt que par un discours authentique. La prolifération des bots et des faux comptes a modifié le paysage de l’engagement politique, permettant à la désinformation de se propager à une vitesse sans précédent.

L'incident du ballon espion chinois (2024)

Un exemple en est un cas qui a eu lieu début 2024, au cours duquel des armées de robots se sont affrontées sur les réseaux sociaux à propos de l'incident du ballon espion chinois. Des chercheurs de l'université Carnegie Mellon ont examiné 1,2 million de tweets en rapport avec l'incident, trouvant des résultats intéressants.

Les tweets chinois étaient principalement artificiels, 641 TP5T d'entre eux ayant été rédigés par des robots. Cependant, les États-Unis ont également utilisé des robots pour tenter de rejeter la faute sur les autres, 351 TP5T de leurs tweets provenant de robots. Cette affaire montre qu'une grande partie du contenu que nous rencontrons quotidiennement sur des plateformes comme Twitter ou Facebook n'est peut-être pas fiable, car il devient de plus en plus difficile de faire la distinction entre les informations réelles et les informations fabriquées.

Référendum sur le Brexit (2016)

Le Dr Marco Bastos a découvert un réseau de robots de médias sociaux qui ont été utilisés pour saturer Twitter de messages électoraux pendant la campagne du référendum sur le Brexit de 2016. L'étude a révélé que 13 493 comptes ont tweeté dans les deux semaines précédant et suivant le référendum.

Ces fausses identités en ligne ont exprimé des opinions et tenté de manipuler l'opinion publique par le biais de tweets en cascade rapides.

Sans surprise, ces profils ont disparu une fois le scrutin terminé. Les recherches menées par la City University sur cette affaire indiquent que « ces fausses identités en ligne exprimaient leurs opinions et tentaient de manipuler l’opinion publique par le biais d’une cascade rapide de tweets ».

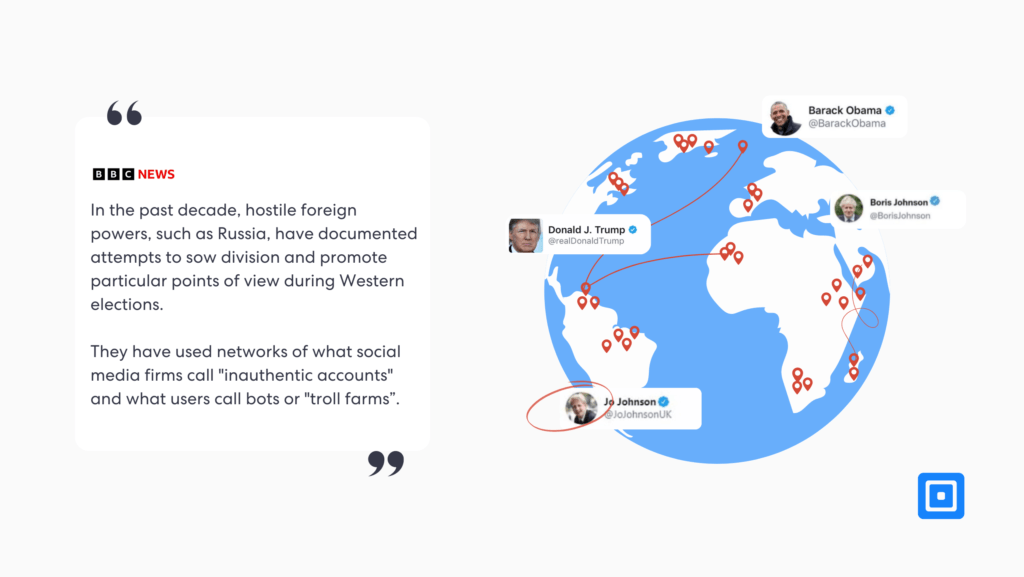

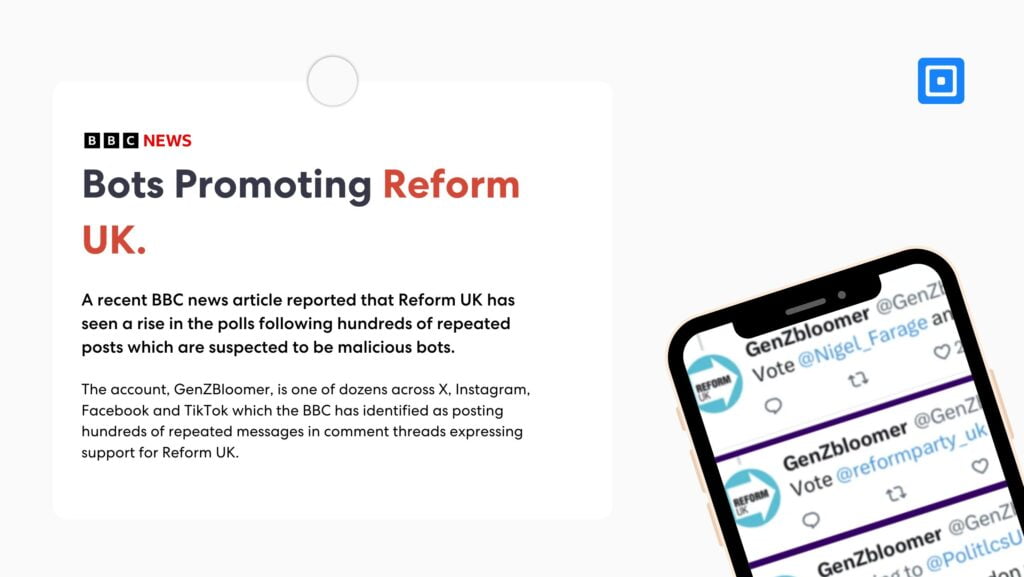

Les robots font la promotion de la réforme au Royaume-Uni (2024)

Un récent Article de presse de la BBC Selon des informations, Reform UK a connu une hausse dans les sondages après la publication répétée de messages suspectés d'avoir été conçus par des robots malveillants. La BBC a décidé d'enquêter davantage sur cette affaire, en contactant les personnes derrière des comptes qui tentent clairement d'exagérer la popularité de Reform UK. Suite à des inquiétudes concernant des interférences étrangères dans d'autres élections, l'enquête a conclu que bon nombre de ces comptes n'étaient pas authentiques.

L’article de la BBC indique : « Au cours de la dernière décennie, des puissances étrangères hostiles, comme la Russie, ont documenté des tentatives visant à semer la division et à promouvoir des points de vue particuliers lors des élections occidentales. Elles ont utilisé des réseaux de ce que les sociétés de médias sociaux appellent des « comptes non authentiques » et ce que les utilisateurs appellent des bots ou des « fermes à trolls ». »

Les chercheurs ont répertorié l'utilisation de robots politiques pour renforcer considérablement les statistiques des médias sociaux des politiciens et des candidats politiques. Donald Trump à Rodrigo Duterte.

Il est difficile d’évaluer l’ampleur de l’influence obtenue par ces formes de manipulation, mais de nombreux journalistes et universitaires sont arrivés à la conclusion qu’elles sont certainement significatives. Des universitaires de Cambridge University Press rapportent que « les chercheurs ont répertorié l’utilisation de robots politiques pour renforcer massivement les statistiques des médias sociaux des politiciens et des candidats politiques de Donald Trump à Rodrigo Duterte.

Reprendre le contrôle de la situation

Il convient de se demander si les plateformes en ligne font suffisamment d’efforts pour freiner la diffusion de contenus malveillants générés par des robots. Les périodes électorales semblent notamment favoriser une augmentation de ce type d’activité, ce qui témoigne d’un manque de systèmes robustes de vérification d’identité.

De nombreuses plateformes de médias sociaux semblent tenter de résoudre le problème en supprimant les faux comptes. Au cours du dernier trimestre 2023, Facebook a supprimé près de 700 millions de faux comptes sur les réseaux sociaux après en avoir supprimé 827 millions au cours du trimestre précédent. Pourtant, quel que soit le nombre d'utilisateurs suspects supprimés, il est certain qu'il en réapparaîtra d'autres. Le problème réside clairement dans le processus d'inscription.

Des mesures plus strictes, comme la vérification de l’identité, pourraient contribuer à réduire considérablement le nombre de ces comptes frauduleux. En fin de compte, garantir l’intégrité des discussions politiques en ligne nécessitera un effort de collaboration entre les gouvernements, les entreprises technologiques et les utilisateurs eux-mêmes.

Prochaines étapes pour des plateformes plus sûres

Les logiciels de vérification d'identité (IDV) offrent une solution sécurisée pour lutter contre le trafic en ligne généré par les robots en appliquant des protocoles stricts d'authentification des utilisateurs et de vérification de l'identité. Ces plateformes peuvent mettre en œuvre plusieurs mesures clés :

Vérifications de documents: Ces contrôles permettent de vérifier que l’identité présentée est authentique et valide en examinant les documents officiels tels que les passeports pour confirmer leur légitimité.

Vérification biométrique:Les contrôles biométriques vont encore plus loin en analysant les micro-expressions faciales subtiles pour garantir que la personne qui présente le document est le véritable propriétaire. La technologie de détection de présence vérifie également que l'utilisateur est physiquement présent et qu'il ne s'agit pas d'un robot ou d'un enregistrement.

verification de l'AGE: La protection des mineurs est essentielle pour créer des environnements en ligne plus sûrs. La vérification de l'âge permet de garantir que les utilisateurs répondent aux critères d'âge, réduisant ainsi le risque d'exploitation ou d'exposition à des contenus préjudiciables.

En intégrant ces techniques, les plateformes IDV peuvent réduire considérablement l'activité des robots, protégeant ainsi les espaces de médias sociaux contre toute utilisation abusive. Ces mesures garantissent que seuls les utilisateurs réels créent des comptes, ce qui freine la propagation du spam, de la désinformation et d'autres activités malveillantes.

Pour plus d'informations sur la façon de protéger votre plateforme en ligne contre la fraude par robot, contactez notre équipe d'experts en conformité.